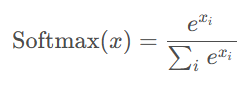

Softmax 函数如上图所示,分子 xi 是每个数据的值,将其指数化,将输出的数值拉开距离。分母是所有数据指数之和,这是一种概率形式,表达为样本占所有值的概率。

它可以用作 Softmax 回归、Softmax 激活函数在神经网络中往往用在最后一层,特别是在处理分类问题时,将网络的原始输出转换为更直观的概率形式。

Softmax 从字面上来说,可以分成soft和max两个部分。

max故名思议就是最大值的意思。Softmax的核心在于soft,而soft有软的含义,与之相对的是hard硬。

很多场景中需要我们找出数组所有元素中值最大的元素,实质上都是求的hardmax。

hardmax 是求一组数据中唯一的最大值,而 Softmax 是输出概率,可以自己选择概率最大的前几个值

什么是softmax回归,如何使用softmax回归,解决多分类任务

Softmax 激活函数:通常用于多分类问题的输出层(最后一层),将 logits(即最后一个线性层的输出)转换成概率分布。

隐藏层激活函数不用 Softmax,用 ReLU、tanh 和 sigmoid 等,用于增加网络的非线性,帮助模型学习复杂的特征表示。

拓展

Sigmoid 函数可以用于二分类,而 Softmax 是多分类

Sigmoid 表达式如下

Sigmoid函数的输出值范围在0到1之间,这使得它能够输出一个概率值。因此,Sigmoid函数常用于二分类问题,其中输出值可以解释为样本属于正类的概率。

在二分类问题中,如果一个样本的Sigmoid函数输出接近1,则可以认为该样本属于正类;如果输出接近0,则认为该样本属于负类。通常,我们会设置一个阈值(例如0.5),如果输出值大于这个阈值,则预测为正类;否则,预测为负类。